Jimmy Jin/Unsplash

Команда исследователей Apple представила новую систему искусственного интеллекта под названием ReALM (Reference Resolution As Language Modeling). Она способна понимать неоднозначные ссылки на объекты на экране, а также учитывать разговорный и контекстный фон, что позволяет более естественно взаимодействовать с голосовыми помощниками.

Что известно

ReALM использует большие языковые модели для преобразования сложной задачи разрешения экранных ссылок в задачу языкового моделирования. Этот подход показал существенный прирост производительности по сравнению с существующими методами.

«Способность понимать контекст, включая ссылки, критически важна для разговорного ассистента», — отмечают исследователи Apple. Они продемонстрировали, что ReALM превосходит даже GPT-4 в решении этой задачи.

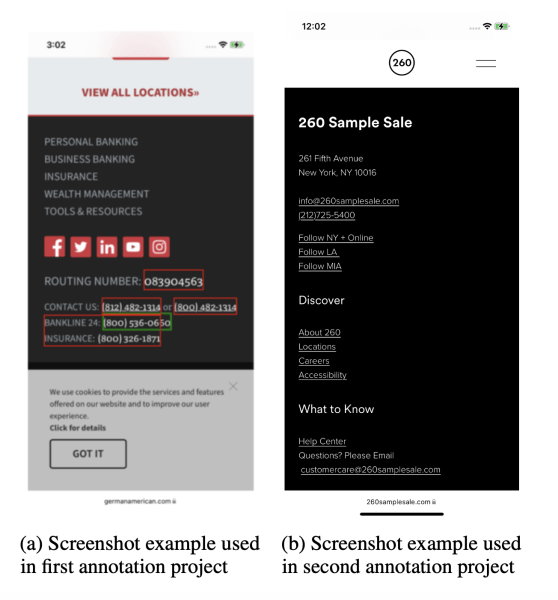

Ключевой инновацией ReALM является реконструкция экрана в текстовое представление, передающее визуальную схему и местоположение объектов. Это в сочетании с тонкой настройкой языковых моделей обеспечило значительные улучшения в разрешении экранных ссылок.

ReALM понимает ссылки на экранные объекты, что позволяет более естественно взаимодействовать с голосовыми помощниками

Исследование подчеркивает потенциал специализированных языковых моделей для решения конкретных задач в производственных системах, где использование огромных сквозных моделей затруднительно. Публикация Apple сигнализирует о ее продолжающихся инвестициях в повышение удобства использования Siri и других продуктов.

Однако авторы предупреждают, что автоматический анализ экранов имеет ограничения. Более сложные визуальные задачи, вероятно, потребуют компьютерного зрения и мультимодальных подходов.

В то время как конкуренты активно внедряют генеративный ИИ, Apple пытается сократить отставание в этой быстро развивающейся области. Ожидается, что на предстоящей конференции WWDC компания представит новые функции на базе больших языковых моделей и искусственного интеллекта.